Die Zukunft der Medien ist synthetisch – eine These, die in der Content-Branche kaum noch angezweifelt wird. Doch wie viele Inhalte werden in Zukunft wirklich durch künstliche Intelligenz erstellt und was ist heute schon möglich? Das haben wir gemeinsam mit Tatjana Anisimov von RTL und Pascal Schröder von Gipfelstürmer Film bei unserer nextMedia.Session diskutiert und konkrete Use Cases besprochen. Für alle, die nicht dabei sein konnten, haben wir die Ergebnisse noch einmal zusammengefasst.

„Synthetische Medien fungieren als Sammelbegriff für Medien wie Video, Bild und Audio, die mit Technologien aus dem Bereich der Künstlichen Intelligenz (KI) verändert oder sogar erzeugt werden“, so steht es im WDR-Zukunftsreport. Im Bereich Audio hat RTL ein Experiment gestartet und die Stimmen von zwei Nachrichtensprecher*innen synthetisiert. Tatjana Anisimov ist Product Innovation Managerin bei RTL, sie hat das Projekt bei der Session vorgestellt und Learnings mit uns geteilt.

„Wie wäre es, wenn sich ntv-Artikel von unseren Moderator*innen vorlesen lassen könnten?“

RTL hat genau das in einem neuen Innovationsprojekt getestet: Mit insgesamt über fünf Stunden Material der Sprecher*innen Maik Meuser und Inken Wriedt hat RTL eine KI von Microsoft gefüttert, um ihre Stimmen zu synthetisieren. Die These: „Nutzer*innen vertrauen unseren TV-Gesichtern und assoziieren ihre Stimmen auch auf auditiver Ebene mit RTL“, erklärt Tatjana Anisimov. Mögliche Anwendungsfelder seien das Vorlesen von Nachrichten, das Vertonen von Videos, Nachrichtenansagen im Radio zu Randzeiten sowie personalisierte und lokalisierte Voice Briefings. Anisimov betont, dass bei jeglichem Einsatz der synthetischen Stimmen jedoch ein vertrauensvoller Umgang mit der Technologie wichtig sei. In ihrem Beispiel bedeute das, den Einsatz der Technologie an den passenden Stellen zu Kennzeichen, erklärt sie.

Nach erstem Einsatz der synthetischen Stimmen und einer anschließenden Befragung der Nutzer*innen, konnte Tatjana Anisimov erste Takeaways mit uns teilen:

- Custom Voice macht den Unterschied

Die Vorlesefunktion werde fast durchgehend als gut bis sehr gut bewertet. Die synthetischen Stimmen von New Hosts würden als natürlicher empfunden in diesem Kontext.

- Prominenz ist sekundär

Prominente Stimmen hätten keinen entscheidenden Einfluss, könnten gegebenenfalls sogar ablenken oder der Glaubwürdigkeit schaden. Wenn der Inhalt nicht zur Stimme passe oder die Stimmen für politische Zwecke genutzt würden, könnten sie zu Vertrauensverlust oder Unsicherheit führen. Beispiel: Kader Loth liest die Nachrichten vor.

- Qualität schlägt Bekanntheit

Wichtiger als die Bekanntheit einer Stimme sei die Aussprachequalität: Pausen, Emotionen, angenehme Stimmlagen und Betonung sowie korrekte Aussprache.

- Barrierefreiheit wird anerkannt

Zuspruch von Menschen mit Seheinschränkungen, die die Funktion gegenüber Browser Readern bevorzugen

- Fremdwörter aktuell noch herausfordernd

Neue Nachrichtenlagen bringen neues Vokabular mit sich, das die Stimmen erst durch menschliches Zutun richtig aussprechen. Beispiel: „King Charles III“ wird als „King Charles drei“ vorgelesen.

- Marathon kein Sprint

Technisch wie auch ethisch wurden sie bei RTL vor neue Herausforderungen gestellt: Wer hat Rechte an den Stimmen? Wie vergütet man Sprecher*innen für diese Leistung?

„Toll, eine AI macht`s“

So lautete der Titel des Impulsvortrages von Pascal Schröder, er ist Geschäftsführer von Gipfelstürmer Film und experimentiert in seinem Arbeitsalltag viel mit künstlicher Intelligenz.

Als Filmemacher weckte das Forschungsprojekt „The Relightables“ von Google sein Interesse: Informatiker bei Google haben ein System für hochwertige, wiederbeleuchtbare Leistungsaufnahmen entwickelt. Das Aufnahmesystem kann die Ganzkörperreflexion menschlicher 3D-Darbietungen erfassen und sie nahtlos in eine neue Umgebung durch Augmented Reality (AR) oder in digitale Film-Szenen einfügen. Die Beleuchtung der Charaktere kann in Echtzeit angepasst werden. Eine Technologie mit enormem Potenzial für die Medienbranche, so Schröder. Nutzer*innen könnten sich zum Beispiel ihre Wunsch-Nachrichten-Moderator*innen aussuchen und sie in ihrem Wunsch-Outfit die Nachrichten vortragen lassen.

Ein passendes Beispiel aus dem WDR-Zukunftsreport, das Schröder zitierte: „Es ist 2023. Ihr öffnet die Nachrichten-App auf Eurem Tablet, tippt auf die Tagesthemen, und Tom Buhrow begrüßt Euch zur aktuellen Ausgabe … persönlich – und mit der Krawatte, die Euch am besten gefällt. Ja, Tom Buhrow hat die Tagesthemen schon 2013 verlassen, aber sein digitaler Zwilling präsentiert sie weiterhin. Das ist nur ein Zukunftsszenario für das Potenzial von synthetischen Medien“

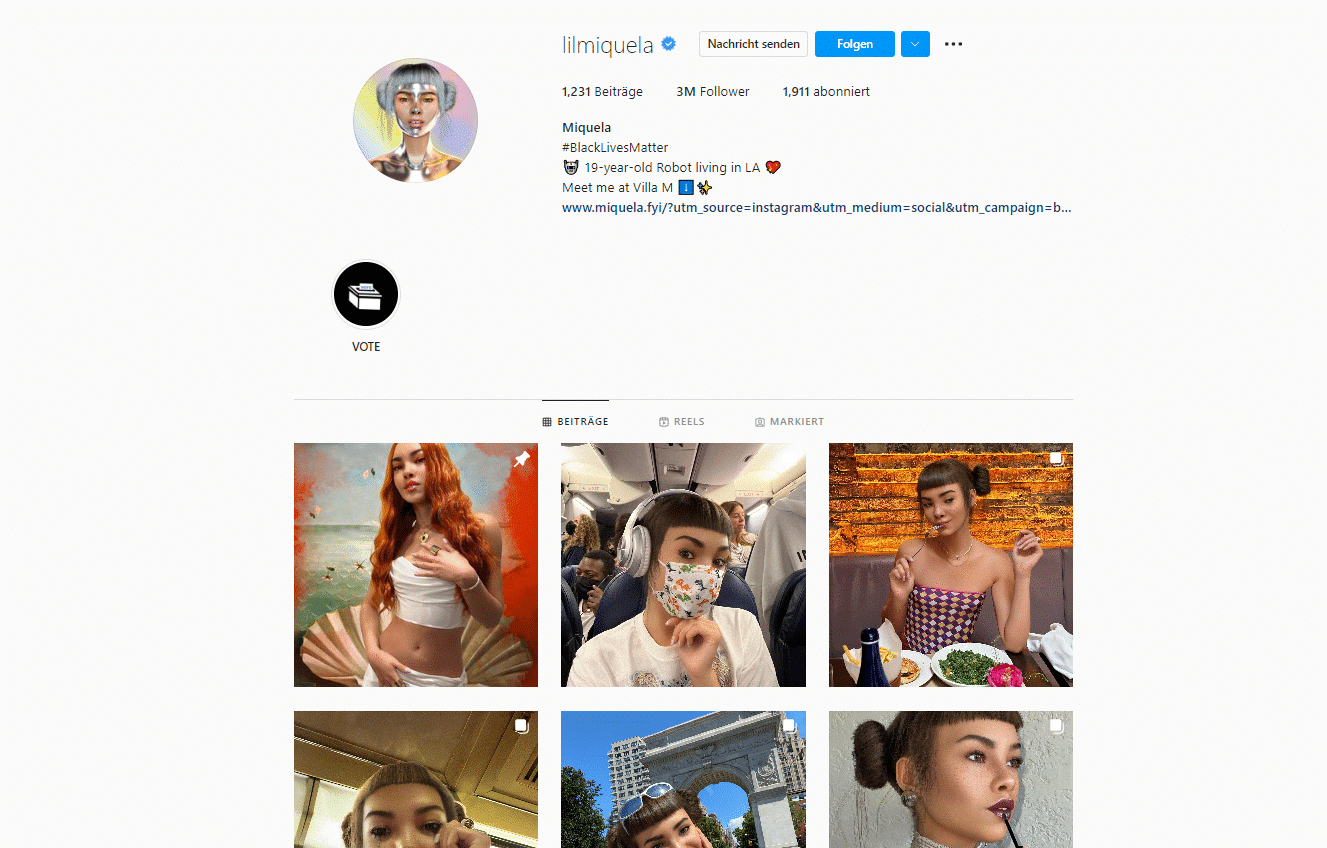

Ein weiteres Phänomen, das Pascal Schröder mit uns teilte: Digitale Menschen. So zum Beispiel der für immer 19-jährige Avatar Lil Miquela, eine computergenerierte Kunstfigur, die bei Instagram drei Millionen Follower*innen hat und schon für Marken wie Calvin Klein und Prada gemodelt hat.

Diese Phänomene und technischen Entwicklungen werfen laut Schröder einige Fragen für die Medienbranche auf:

- Wie sollten Medien mit der rasanten Zunahme von Deepfakes umgehen?

- Wie verändern sich Jobprofile und Tätigkeiten durch synthetische Medien?

- Wie entwickelt sich die Vertrauensbeziehung zwischen Medien und Konsument*innen?

- Welche neue Konkurrenz kommt durch synthetische Medien auf Medienhäuser zu?

- Welche lizenzrechtlichen Fragen entstehen durch Erfassung und Generierung von Daten im Kontext von synthetischen Medien, zum Beispiel bei der Digitalisierung von Gesichtern, Körpern oder Stimmen von Moderator*innen?

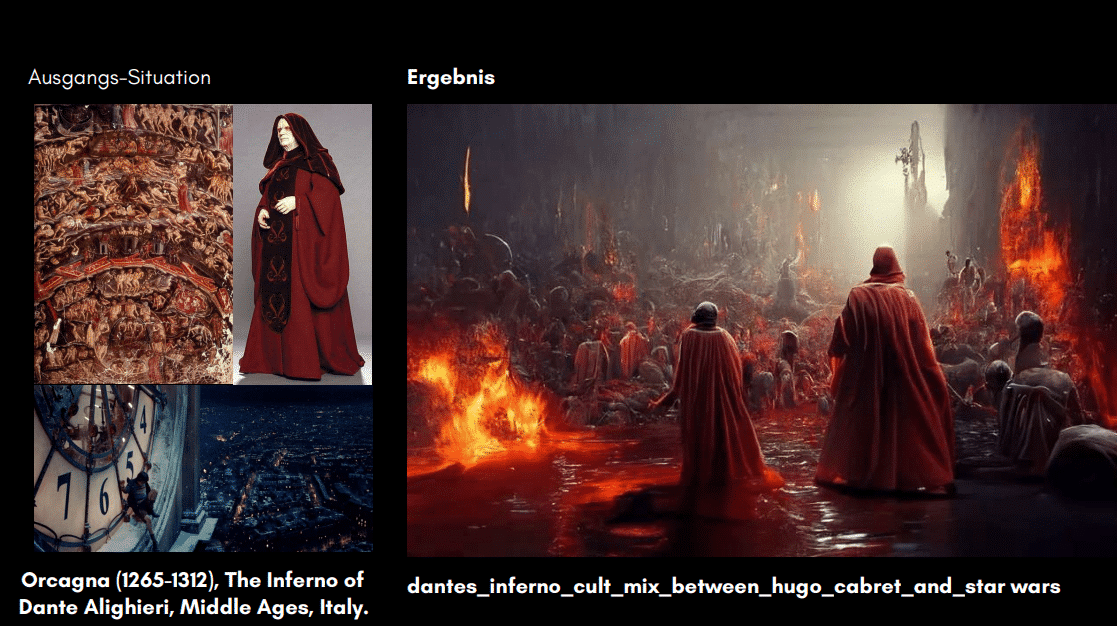

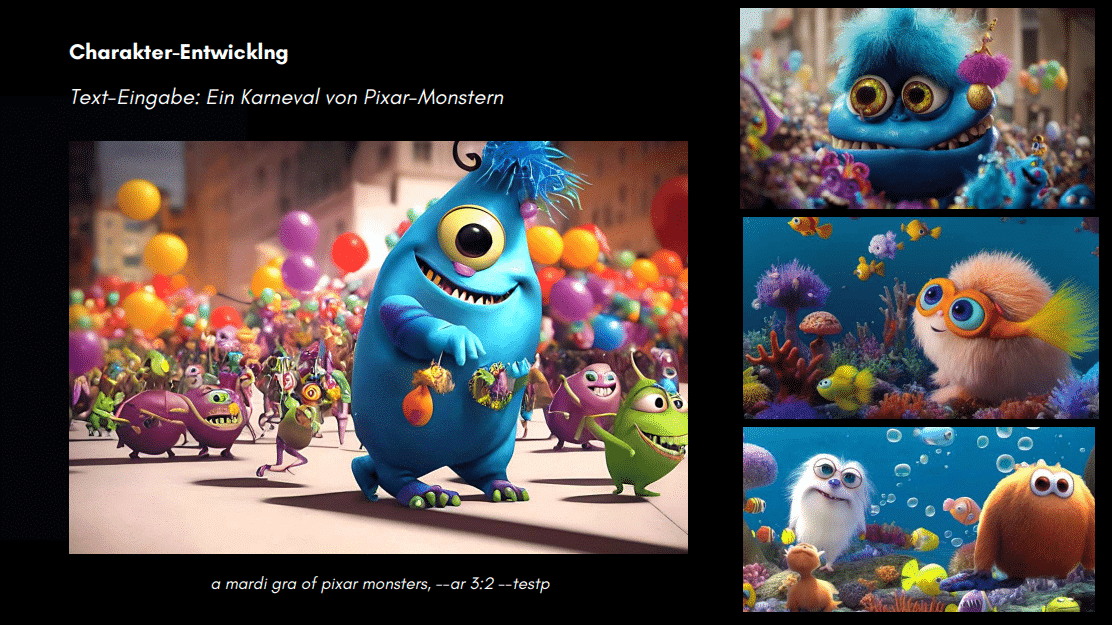

Inspirationssuche und Bildgenerierung durch AI

Im zweiten Teil seines Vortrages teilte Pascal Schröder konkrete Use Cases aus seinem Arbeitsalltag mit uns. Wie in den folgenden Beispielen zu sehen ist, nutzt er synthetische Medienproduktion bereits für die Inspirationssuche und Bildgenerierung mithilfe der Programme Dalle-E und Midjourney.

Sein Fazit:

- AI hilft, sich Inspiration zu holen, als würde man googlen

- AI kann dein Grafik-Assistent sein, der die Vorschläge nach deinen Vorgaben erstellt, um Zeit zu sparen

- Ai kann dir komplexe Mood-Bilder erstellen, um deine Vision zu visualisieren, selbst wenn du die Grafikprogramme wie Photoshop nicht gut beherrschst

Verbesserungspotenzial sieht er jedoch in dem intensiven Zeitaufwand: Sobald man sehr klare Vorstellungen habe, würde das richtige Füttern der KI viel Zeit beanspruchen. Zudem resümiert er: „Ohne die menschliche Vision, bleibt es ein Zufallsprodukt.“

Wir haben die sechste nextMedia.Session gemeinsam mit der MOIN Filmförderung durchgeführt. Ihr möchtet die nächste Session mitgestalten? Dann meldet euch gern bei uns.

Weitere Artikel

„Zu Beginn waren wir die großen Internet-Erklärer“

Wolfgang Macht – Mitgründer der Netzpiloten, Pionier der deutschen Start-up-Szene und Digital-Enthusiast durch und durch, blickt mit uns auf die Entstehung und die Zukunft der digitalen Revolution. Im Interview konnten wir darüber sprechen, wer die Netzpiloten sind, was er am Standort Hamburg schätzt und wie er die KI-Entwicklungen einordnet.

Standortinitiative nextMedia.Hamburg gewinnt weitere Partner für den Innovationsraum SPACE

ZEIT ONLINE und die pilot Agenturgruppe sind ab sofort SPACE-Partner von nextMedia.Hamburg. Mit dem Engagement der beiden Unternehmen erweitert nextMedia die Anzahl der SPACE-Partnerschaften auf zwölf.

Themenfestival „Attention Economy“ startet am Montag in Hamburg

Die Standortinitiative nextMedia.Hamburg lädt die Medien- und Digitalwirtschaft zum zweiten Themenfestival ein. Vom 24. bis 27. Juni dreht sich im Hamburger Innovationsraum SPACE alles um das Thema „Attention Economy“.

nextMedia.Hamburg fördert erneut fünf innovative Start-ups im Media Lift Inkubator 2024

nextMedia.Hamburg fördert erneut fünf innovative Start-ups im Media Lift Inkubator 2024 Pressemitteilung als PDF Hamburg, 13. Juni 2024 – nextMedia.Hamburg gibt die fünf ausgewählten Teams

nextMedia.Hamburg fördert erneut fünf innovative Start-ups im Media Lift Inkubator 2024

nextMedia.Hamburg gibt die fünf ausgewählten Teams für den Media Lift Inkubator 2024 bekannt. Der Inkubator unterstützt vielversprechende Start-ups an der Schnittstelle von Content und Technologie.

Nettwerk Music Europe Geschäftsführer Martin Schuhmacher im Interview

Hamburg ist um ein Musiklabel reicher. Das kanadische Label

Nettwerk hat im vergangenen Jahr seinen Europa Headquarter, die

Nettwerk Music Europe GmbH, in Hamburg eröffnet. Wieso sich das Label für den Standort Hamburg entschieden hat, wie das Label versucht Artist langfristig aufzubauen und welche Auswirkungen AI-Entwicklungen auf die Musikbranche haben, darüber konnten wir mit Geschäftsführer Martin Schuhmacher sprechen.